[羅戈導讀]大家好,首先感謝主辦方光博會和智東西給我提供一個機會與大家分享下,我們公司在移動機器人領域涉及到的3D視覺技術,本次演講的主題為《3D視覺在室內移動機器?中的應用與展望》,主要分為以下5個部分

[羅戈導讀]大家好,首先感謝主辦方光博會和智東西給我提供一個機會與大家分享下,我們公司在移動機器人領域涉及到的3D視覺技術,本次演講的主題為《3D視覺在室內移動機器?中的應用與展望》,主要分為以下5個部分

大家好,首先感謝主辦方光博會和智東西給我提供一個機會與大家分享下,我們公司在移動機器人領域涉及到的3D視覺技術,本次演講的主題為《3D視覺在室內移動機器?中的應用與展望》,主要分為以下5個部分:

1、使用場景

2、室內環境的特點

3、傳感器

4、使用方式及問題

5、展望

炬星科技是一家比較年輕的公司,成立于2018年5月,同時也是一家基于室內移動機器人倉庫自動化解決方案的提供商。上圖是目前量產的機器人,傳感器分布已經在上面標注出來,使用的是主動雙目立體視覺傳感器,這也是今天演講圍繞的傳感器,為了保障機器人的可靠性,不僅使用主動雙目傳感器,還有超聲傳感器,由于光學傳感器對玻璃沒辦法,主要靠超聲,上圖的機器人上也有超聲傳感器,下面還有一個單線激光雷達、里程計+IMU。

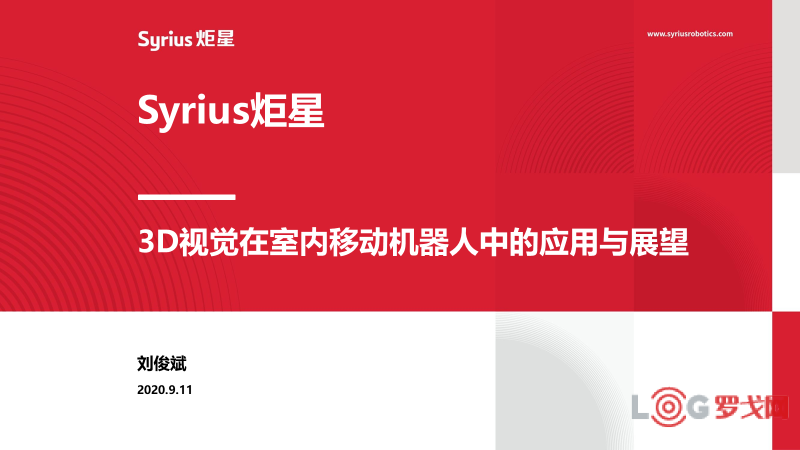

上圖是一個典型應用,在現在的倉儲物流尤其是電商倉庫里,主要是通過人力揀選的方式,一個人拿到訂單后到貨架上把物品撿回來,最后打包,一個人一天最多可以走20公里,我們提供的解決方案是用機器人自動化的方式代替人行走,可以提高2-3倍效率,并且在應對倉庫出貨量波動方面具備高度的靈活性。

相較比于室外場景,室內大部分是結構化的場景,室內的東西都是人造的,但有時結構特征非常不清晰,比如長直走廊沒有結構化特征。另外一個方面,我們所面對的倉庫場景結構化特征重復的概率極大,在一排貨架看到的結構場景與隔壁一排看到的場景幾乎一樣。所有的室內定位要么用UWB方案,要么用傳感器感知,我們采取的是傳感器感知,因為安裝采用UWB的方案,部署成本太高。室內還會出現非常狹窄的情況,貨架之間可能只有1米,造成機器人運動困難。對于光照,室內光照相對友好,但也會遇到一個問題就是強光,還有的倉庫周圍是玻璃,太陽光返到地面會造成視覺傳感器過曝。

那為什么選擇室內場景落地機器人技術?因為它的復雜度相對較低,可以被拿來真正產生社會價值,而像比較流行的自動駕駛,未來技術路線還有一段時間,沒法馬上產生價值。

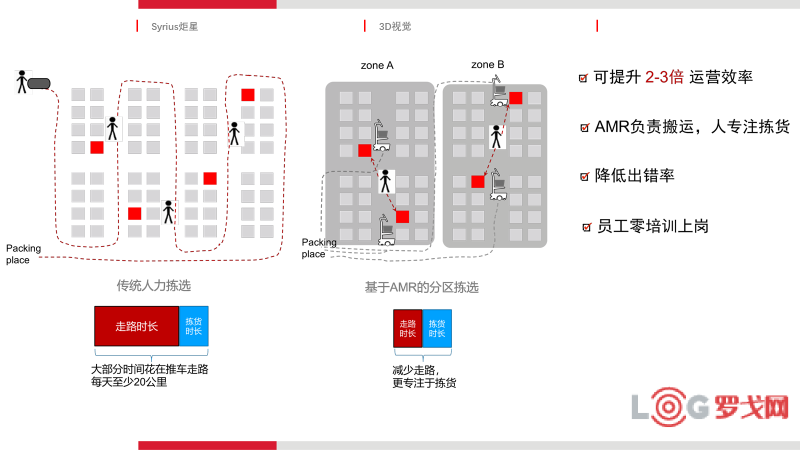

下面簡單介紹下3D視覺傳感器的主流方案,總結了六種方案:雙目、結構光、主動雙目、dToF、PM-iToF、CW-iToF,實際可能會更多一些。上圖左邊的三個方案基于三角法,右邊是三個方案基于TOF。

上圖是總結的基于三角測距的原理,下面介紹下主動雙目的特點,主動雙目相較于雙目相機的第一個優勢是有一個IR發射器,第二個優勢在于發出的是結構光,室內有很多白墻,可以同樣進行雙目匹配,而這個點在雙目相機是沒有的。

接下來看下ToF,ToF總結了三種,第一種是dToF,它的難點在于,假設測量距離是3米,時間差是納秒級的,芯片非常難造,在激光雷達方面,像車載的激光雷達、旋轉式激光雷達也是基于dTOF,中間是PM-iToF是間接ToF方法,接收器接收兩個脈沖,有兩個積分窗口,我們可以積分出兩個信號出來,通過這兩個信號的比值計算時間。CW-iTOF是通過發射信號和接收信號的相位差計算飛行時間。

雙目在室外比較主流,室內暗的地方比較難解決,而且沒有紋理的地方解決不了,雙目結構光是中等距離,它的測距在5-8米。i-ToF是中短距離,國內廠商做i-TOF比較多,都有自己的一套解決方案,d-ToF做得相對少一些,它存在近距離的精度問題,因為距離越近,測量越難。

炬星選擇的視覺方案是主動雙目光,除了主動雙目光,我們還在模組上加了全局快門魚眼相機和IMU,魚眼相機的角度非常大,拍的特征非常全,全局快門沒有滾動快門的缺點,我們選擇這款相機主要是為了支持我們的應用,一個是語義導航,一個是更準幫助定位。

下面介紹下傳統的3D感知怎么用于避障。首先拿到一個深度圖,3D是可以直接輸出的,有的3D相機也有直接輸出點云的,上圖第二張圖片可以看到這塊是一個地面,和地面上的障礙物。先進行地面檢測,把地面和障礙物分開,把障礙物投影到當前地圖上,路徑規劃就會繞開這個障礙物,這是所有廠商都在用的方式,但是和我們現在用的方式稍微有點區別。

我們做的是基于深度學習的語義導航,把圖片識別和深度相機結合起來,在一個圖像上識別到一個人,深度圖上知道這個人的位置,我畫在這上面時知道是一個人,當它是一個靜態障礙物時,我知道它是一個箱子。

上圖是一個靜態障礙物時機器人的行為,如果是靜態障礙物,機器人離這個箱子不到10公分避障,如果是一個人,機器人稍微等一下,因為對于人來說,人是運動的,機器人可以繞過它,但是離得太近,人一動機器人可能來不及反映,為了保障安全,我們需要知道前面看到的障礙物是人還是靜態的障礙物。

3D相機第二個應用是利用3D相機進行更精確的機器人狀態估計,就是把3D信息融合到視覺SLAM里。先介紹下視覺SLAM的幾種方案,視覺SLAM一般在工業機器人都加入了IMU。由于雙目相機市面上大部分是大廣角的,魚眼相機能計算的特征深度準確性相對差一些,這幾個原因都會導致一個問題,在現有的視覺方案中,對于一個特征點的3D坐標估計要么是不準,要么是估計不出來,對3D坐標估計恰恰是視覺SLAM的核心要素,因為它都是靠誤差來構造它的優化函數,我們“有機會”地把3D信息融合進去,在有3D信息時,直接拿3D信息構建殘差。因為3D信息非常有限,3D傳感器的角度不是魚眼,而且高精度的距離只有5米,“有機會”地拿這個信息進行融合,就可以解決上述的問題。

第一個大方向是如何獲取3D信息?傳感器未來會往哪里走?現在的三角法測距瓶頸在于機械,基線越大,距離越遠,對于80公分寬的機器人,基線越大,模組的標定越困難,據我了解三角法的工藝已經到了極限,再往大會非常困難,i-ToF是現在很多廠商的發力重點,未來我認為d-ToF是廠商的發力重點。

第二個方向是基于深度學習的3D生成也是未來的方向,上面的文章總結2014-2019年所有用視覺生成3D信息的方法,不用特別高精的傳感器,只用相機生成一個3D信息,它生成3D信息可能不那么準,如果要做一些非常簡單的識別和避免碰撞,這個還是可以滿足的。

第三個方向是基于多傳感器融合的3D生成,這篇文章比較有意思,它把一個16線的激光雷達和單目相機融合生成全景的3D圖,16線激光雷達只有16線,一個全景圖有幾百條線,在幾百條線上做感知的應用比16個線簡單得多。

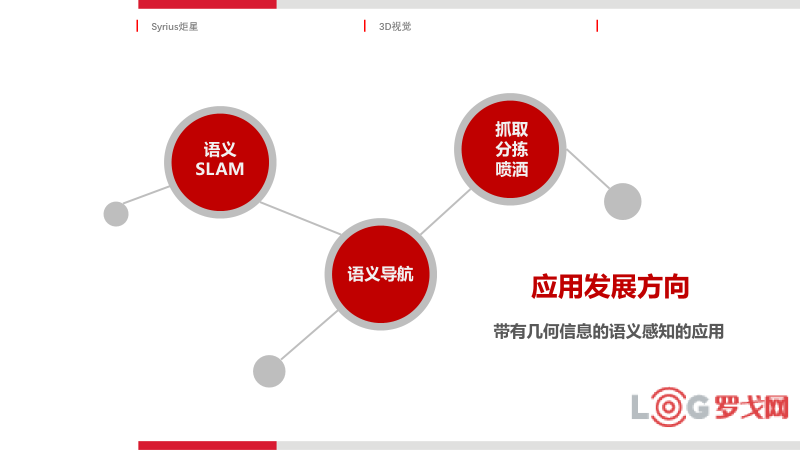

對于應用來說,它的落腳點在哪里?我認為帶有幾何信息的語義感知的應用,3D傳感器同時能給到語義信息以及對應的幾何信息,首先它支持更高精的定位,語義SLAM是現在研究界大的發展方向,語義信息可以在前端匹配,后端優化,以及回環檢測等。語義導航根據不同的情況采取不同的導航策略實現不同的功能,帶有幾何的語義感知應用還有哪些?剛才看到的抓取、分揀,疫情期間有很多機器人在醫院里面噴灑藥物,我知道哪里人聚集得多,哪里人聚集得少,可以更精確噴灑藥物。比如掃地機器人,知道前面是一個地毯,可以更精準的打掃等,這一系列的應用都是基于幾何信息和語義信息的結合,我認為這是未來3D傳感器的發展方向。

今天的演講就到這里,謝謝!

中郵無人機(北京)有限公司揭牌

2755 閱讀

智能倉儲企業“智世機器人”完成數千萬元A輪融資

2656 閱讀

這家老牌物流巨頭被整合重組,四千多名員工將何去何從?

2089 閱讀2024最值錢的物流上市企業是誰?哪些物流企業被看好,哪些被看跌?

1625 閱讀地緣政治重塑下的全球供應鏈:轉型、挑戰與新秩序

1298 閱讀物流供應鏈領域“吸金”不力,但能給投融資事件頒幾個獎

1308 閱讀連續5年的“春節主力軍”,德邦為何如此穩?

1177 閱讀16連冠背后,日日順助力智家工廠物流降本增效

1085 閱讀1745億件,快遞業務量增速超預期

1029 閱讀扎根供應鏈創新25年,一家“耐力長跑型”企業的破局啟示

977 閱讀

登錄后才能發表評論

登錄